Co to jest Screaming Frog SEO Spider?

Screaming Frog SEO Spider jest cennym narzędziem do optymalizacji serwisu pod wyszukiwarki (np. Google), ponieważ może pomóc w analizie struktury witryny i znalezieniu problemów technicznych, które mogą wpływać negatywnie na pozycje w wyszukiwarkach.

Spis treści

Co to jest Screaming Frog?

Screaming Frog SEO Spider jest potężnym i elastycznym crawlerem witryn, zdolnym do efektywnego skanowania zarówno małych, jak i bardzo dużych stron internetowych, jednocześnie umożliwiając analizę wyników w czasie rzeczywistym. Zbiera kluczowe dane onsite, które pozwalają na podejmowanie świadomych decyzji dotyczących SEO.

Oto kilka dodatkowych rzeczy, które powinieneś wiedzieć o Screaming Frog:

- Jest dostępny zarówno dla systemów Windows, jak i Mac.

- Ma bezpłatną wersję, która umożliwia skanowanie serwisu do 500 adresów URL, oraz wersję płatną, która zapewnia nieograniczone crawlowanie.

- Nie służy tylko do celów SEO - może być również używany do audytów stron internetowych i analiz konkurencji.

Dlaczego warto używać Screaming Frog?

Jest to szybkie i zaawansowane narzędzie do wykonywania audytu SEO.

Screaming Frog może skanować małe i duże strony internetowe.

Można wyeksportować podstawowe elementy dotyczące SEO (adresy URL, tytuły stron, meta opisu, nagłówki i inne) do arkusza kalkulacyjnego, dzięki czemu można go łatwo wykorzystać jako podstawę do rekomendacji SEO.

Zalety Screaming Frog

Niektóre funkcje opisane poniżej mogą być niedostępne w darmowej wersji Screaming Frog.

Znajdź uszkodzone linki

Błyskawicznie przeszukaj stronę internetową i znajdź niedziałające linki (404) i błędy serwera. Screaming Frog może masowo wyeksportować błędy i źródłowe adresy URL, aby je naprawić lub wysłać do dewelopera.

Analizuj tytuły stron i dane meta

Przeanalizuj tytuły stron i meta opisy podczas skanowania i zidentyfikuj te, które są zbyt długie, krótkie, których brakuje lub które są zduplikowane w całej witrynie.

Wyciąganie danych za pomocą XPath

Zbierz dowolne dane z HTML strony internetowej używając CSS Path, XPath lub regex. Może to obejmować meta tagi społecznościowe, dodatkowe nagłówki, ceny, SKU i wiele innych!

Generuj mapy witryn XML

Screaming Frog szybko tworzy mapy witryn XML oraz graficzne mapy witryn XML, z zaawansowaną konfiguracją adresów URL, aby uwzględnić, ostatnią modyfikację, priorytet i częstotliwość zmian.

Crawluj strony internetowe w JavaScript

Renderuj strony internetowe za pomocą zintegrowanego Chromium WRS do crawlowania dynamicznych stron internetowych. Screaming Frog obsługuje również frameworki, takie jak Angular, React i Vue.js.

Zaplanuj audyt

Zaplanuj uruchamianie indeksowania w wybranych odstępach czasu i automatycznie eksportuj dane indeksowania do dowolnej lokalizacji, w tym do Arkuszy Google. Lub zautomatyzuj całkowicie za pomocą wiersza poleceń.

Wykonaj audyt przekierowań

Znajdź tymczasowe i stałe przekierowania, zidentyfikuj łańcuchy i pętle przekierowań lub prześlij listę adresów URL do audytu podczas migracji witryny.

Znajdź zduplikowane treści

Wykrywaj dokładnie zduplikowane adresy URL za pomocą algorytmu sprawdzania md5, częściowo zduplikowane elementy, takie jak tytuły stron, opisy lub nagłówki, i znajduj strony o niskiej zawartości.

Przejrzyj plik robots.txt i dyrektywy

Zobacz adresy URL zablokowane przez robots.txt, meta robots lub dyrektywy X-Robots-Tag, takie jak "noindex" lub "nofollow", a także tagi kanoniczne oraz rel="next" i rel="prev".

Integracja z GA, GSC i PSI

Połącz się z interfejsami API Google Analytics, Search Console i PageSpeed Insights i pobierz dane o użytkownikach i wydajności dla wszystkich adresów URL podczas skanowania serwisu, aby uzyskać lepszy wgląd.

Wizualizuj architekturę witryny

Oceniaj wewnętrzne łącza i strukturę adresów URL za pomocą interaktywnych diagramów indeksowania i katalogów oraz wizualizacji witryny w formie wykresu drzewa.

Porównaj skanowania serwisu

Śledź postęp problemów i możliwości SEO oraz zobacz, co się zmieniło między skanami w Screaming Frog. Porównaj etapy ze środowiskami produkcyjnymi, korzystając z zaawansowanego mapowania adresów URL.

Jak korzystać ze Screaming Frog?

Jeśli nigdy wcześniej nie korzystałeś z Screaming Frog, zapoznaj się z ich przewodnikiem wprowadzającym.

A jeśli już go używasz, upewnij się, że w pełni wykorzystujesz jego funkcje, czytając dokumentację.

Screaming Frog posiada szeroką gamę materiałów do nauki, którą można znaleźć w sekcji samouczków na oficjalnej stronie internetowej Screaming Frog.

Wniosek

Jeśli poważnie myślisz o poprawie SEO swojej witryny, Screaming Frog to narzędzie, którego potrzebujesz w swojej kolekcji.

Crawlowanie stron internetowych i zbieranie danych na ich temat to skomplikowane zadanie. Ale to narzędzie porządkuje informacje w bardziej zorganizowany sposób, aby ułatwić Ci pracę.

Korzystanie z niego nie zawsze jest łatwe, ale warto podjąć wysiłek, aby dowiedzieć się, jak najlepiej z niego korzystać.

Jesteś w stanie naprawić problemy, które negatywnie wpływają na Twoje rankingi w wyszukiwarkach.

Płatna wersja Screaming Frog może być lepsza, ponieważ zawiera więcej dostępnych funkcji niż wersja darmowa.

Aktualizacje Screaming Frog

W sekcji aktualizacje Screaming Frog zostały zawarte informacje o ostatnich aktualizacjach i zmianach wprowadzonych w aplikacji. Changelog umożliwia użytkownikom śledzenie rozwoju narzędzia i korzystanie z najnowszych funkcji.

Screaming Frog SEO Spider 18.0

Firma Screaming Frog ogłosiła wydanie nowej wersji swojego popularnego narzędzia SEO Spider, oznaczonej numerem 18.0 i nazwie kodowej "Willow". Wprowadzono szereg nowych funkcji oraz ulepszeń, które będą szczególnie przydatne dla specjalistów SEO.

Integracja z GA4

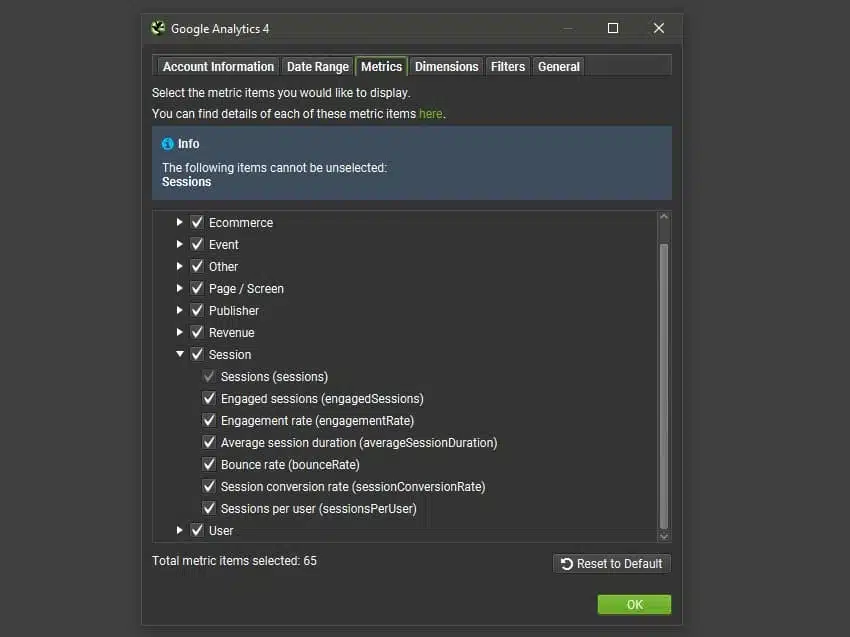

Narzędzie SEO Spider w wersji 18.0 oferuje teraz integrację z GA4, czyli najnowszą wersją Google Analytics. Użytkownicy mogą połączyć się z GA4 i pobierać dane analityczne podczas indeksowania witryny. Wystarczy skonfigurować połączenie w sekcji "Config > API Access > GA4" i wybrać spośród 65 dostępnych metryk.

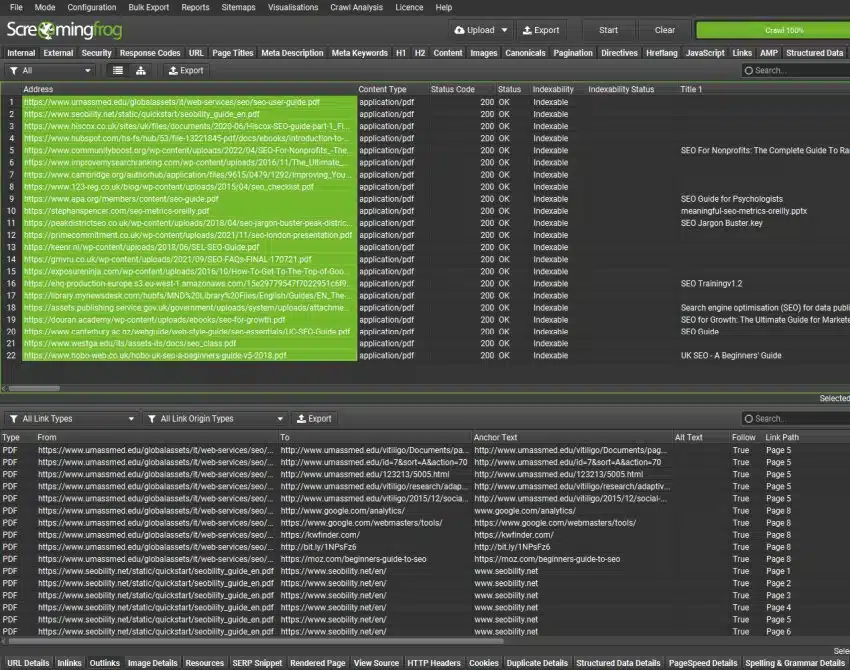

Analiza plików PDF

W odpowiedzi na prośby wielu klientów, wersja 18.0 SEO Spider umożliwia również skanowanie plików PDF. Narzędzie analizuje zawarte w nich linki i wyświetla tytuł dokumentu jako tytuł strony. Dzięki temu użytkownicy mogą sprawdzić, czy linki w plikach PDF działają poprawnie, a ewentualne problemy z linkami będą raportowane w zakładce "Response Codes".

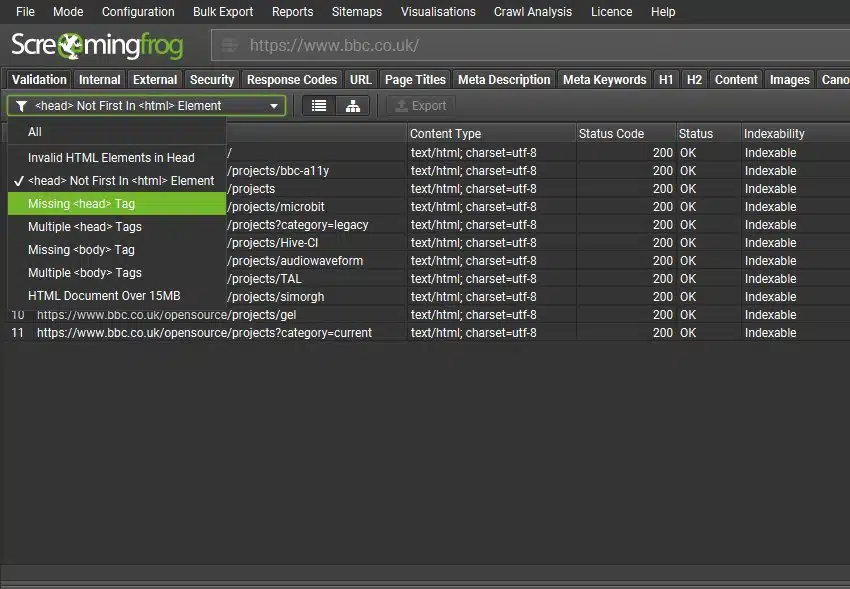

Nowa zakładka "Validation"

W SEO Spider 18.0 wprowadzono również nową zakładkę "Validation", która wykonuje podstawowe walidacje zgodności z najlepszymi praktykami SEO. Celem tej zakładki jest identyfikacja problemów, które mogą utrudniać botom wyszukiwarek analizowanie i indeksowanie stron. Wprowadzono kilka nowych filtrów, które pomogą wychwycić problemy związane z kodem HTML strony.

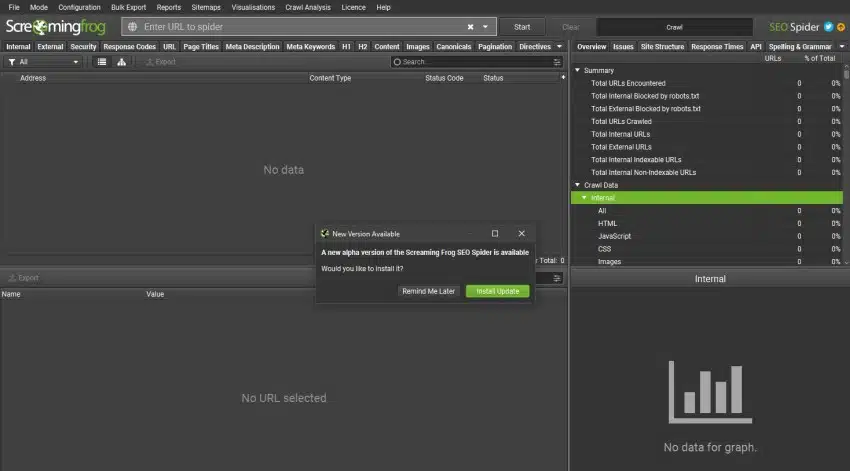

Aktualizacje w aplikacji

Aby ułatwić użytkownikom aktualizowanie SEO Spider, wprowadzono wersję 18.0, która obsługuje aktualizacje w aplikacji. Oznacza to, że użytkownicy będą informowani o dostępnych aktualizacjach bezpośrednio w programie, które zostaną pobrane w tle. Wystarczy kilka kliknięć, aby zainstalować nową wersję.

Uwierzytelnianie dla harmonogramów i CLI

Wprowadzono ulepszenia w zakresie uwierzytelniania dla harmonogramów i interfejsu wiersza poleceń (CLI). Teraz można łatwo skonfigurować uwierzytelnianie zarówno dla standardowych metod, jak i formularzy na stronach internetowych. Wystarczy wprowadzić dane uwierzytelniające w sekcji "Config > Authentication".

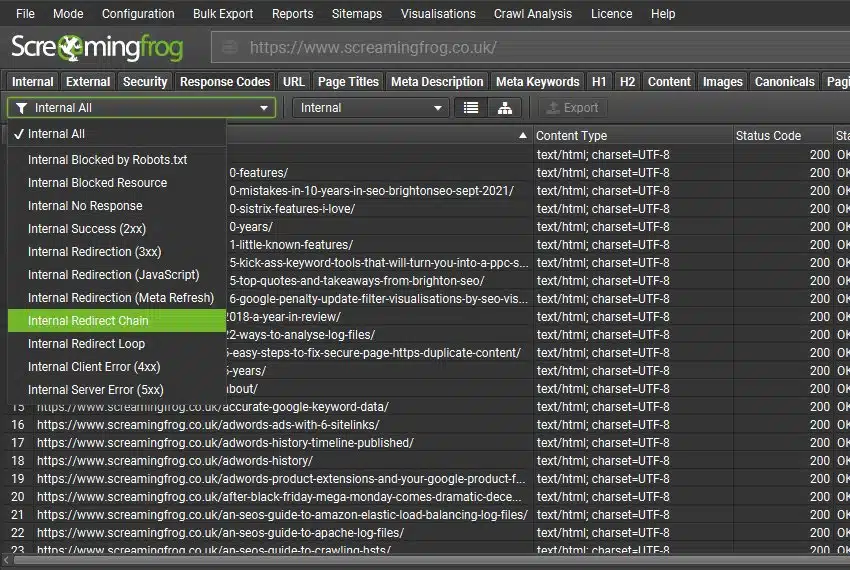

Nowe filtry i problemy

Wprowadzono także różne nowe filtry i problemy, które pomogą lepiej filtrować dane oraz identyfikować problemy wykryte podczas analizy witryny. Wśród nich znajdują się:

- Filtr "Redirect Chains"

- Filtr "Redirect Loop"

- Filtr "Background Images"

- Filtr "Multiple Conflicting Canonicals"

- Filtr "Canonical Is Relative"

- Filtr "Unlinked Canonicals"

- Filtr "Non-Indexable Page Inlinks Only"

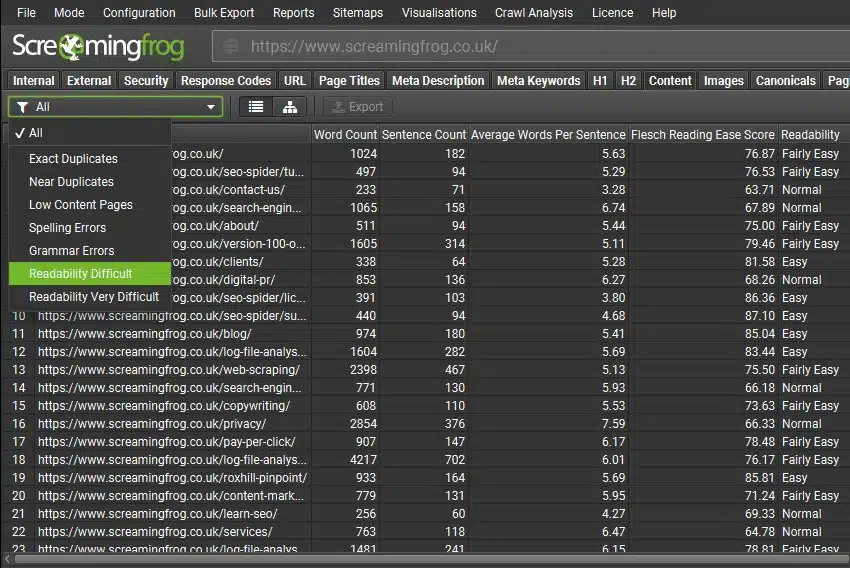

Wskaźniki czytelności Flesch

Wskaźniki czytelności Flesch zostały dodane w zakładce "Content" z nowymi filtrami "Readability Difficult" i "Readability Very Difficult". Warto zauważyć, że wskaźniki te są odpowiednie dla języka angielskiego, a w przyszłości może zostać dodane wsparcie dla innych języków. Wskaźniki czytelności można wyłączyć w "Config > Spider > Extraction".

Inne aktualizacje

- Autouzupełnianie w pasku adresu

- Kolorowanie kodów odpowiedzi w wizualizacjach

- Wybór źródła mapy strony XML w harmonogramowaniu

Więcej szczegółów na stronie: https://www.screamingfrog.co.uk/seo-spider-18/

Screaming Frog SEO Spider 17.0

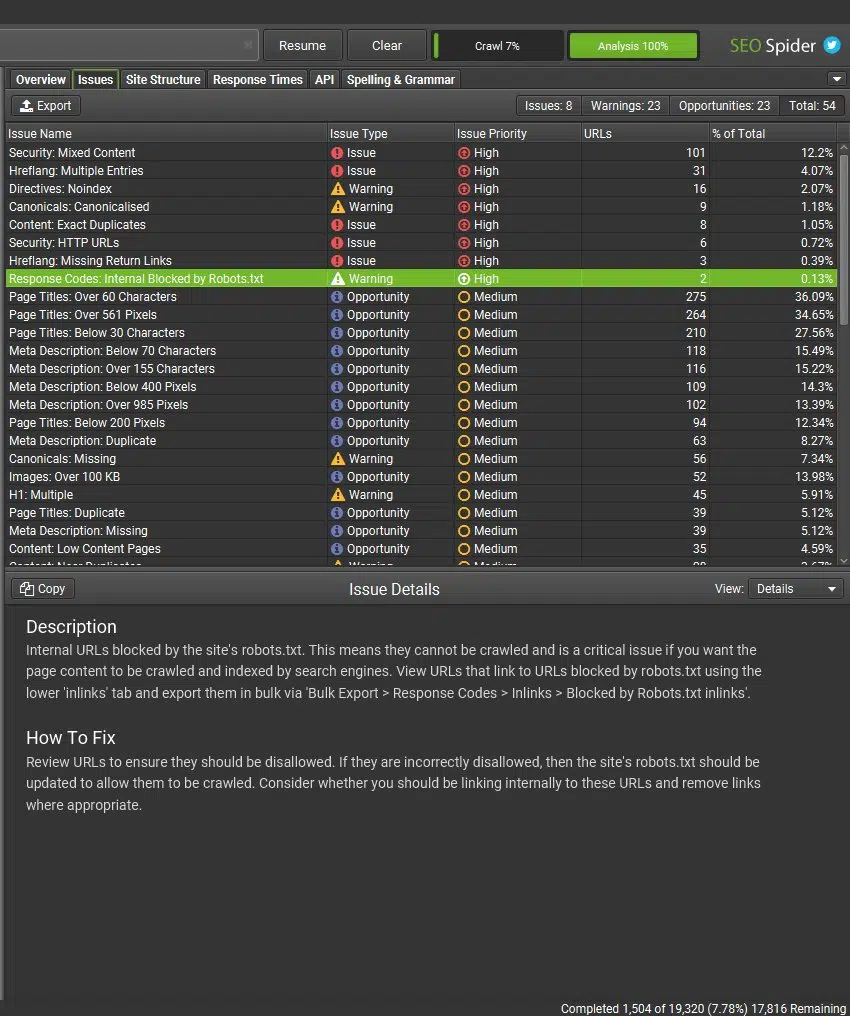

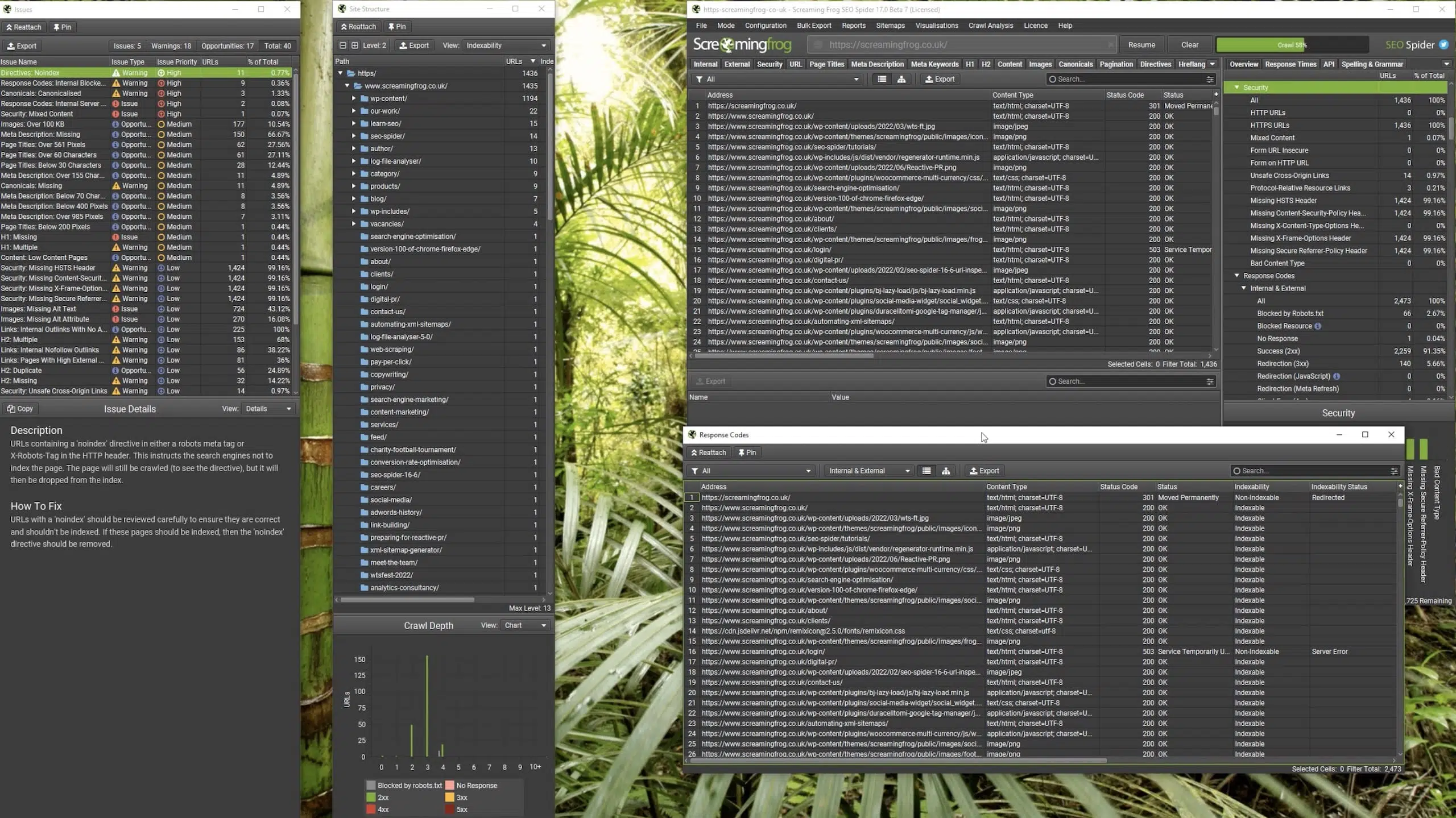

Zakładka Problemy

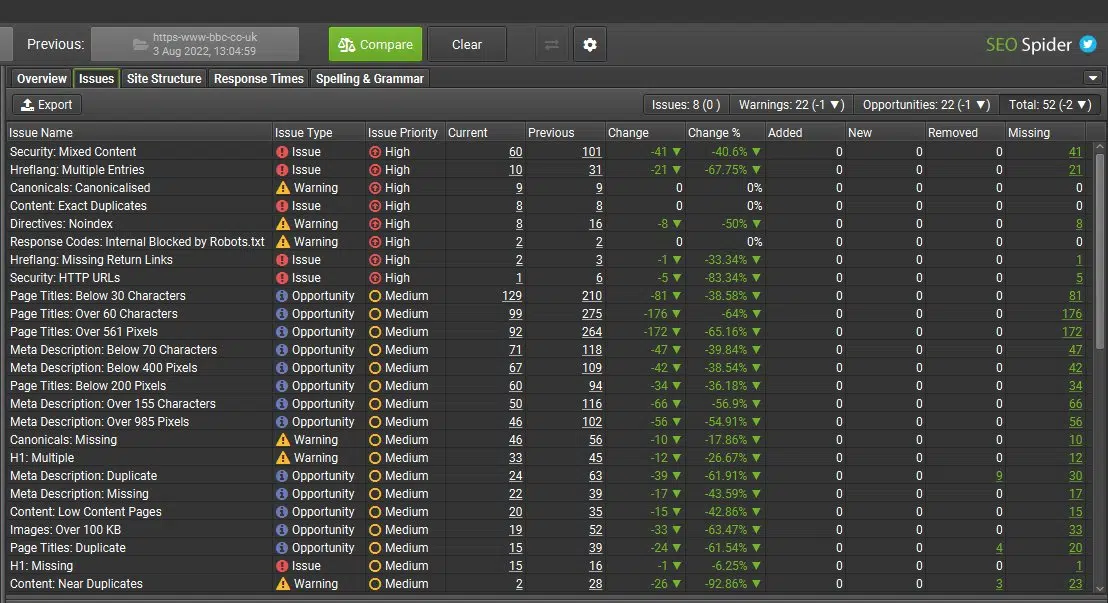

W narzędziu Screaming Frog dostępna jest nowa karta „Issues”, która zawiera szczegółowe informacje o wykrytych problemach, ostrzeżeniach i możliwościach.

Ta karta została wprowadzona, aby pomóc lepiej kierować użytkowników do potencjalnych problemów i obszarów wymagających poprawy, na podstawie istniejące filtry z karty "Overview".

www.screamingfrog.co.uk

Opisy każdego problemu i potencjalnych działań są dostępne w języku angielskim, niemieckim, hiszpańskim, francuskim i włoskim.

Każda pozycja ma przypisany rodzaj i szacowany priorytet w oparciu o potencjalny wpływ.

- "Issues" to błędy lub problemy, które najlepiej byłoby naprawić.

- "Opportunities" to potencjalne obszary optymalizacji i doskonalenia.

- "Warnings" niekoniecznie stanowią problem, ale należy je sprawdzić i ewentualnie naprawić.

Dla doświadczonych użytkowników nowa karta "Issues" jest przydatnym sposobem szybkiego identyfikowania problemów najwyższego poziomu i bezpośredniego zagłębiania się w nie jako alternatywa dla karty "Overview". Użytkownikom o mniejszej wiedzy na temat SEO pomoże to zapewnić więcej wskazówek dotyczących optymalizacji witryny.

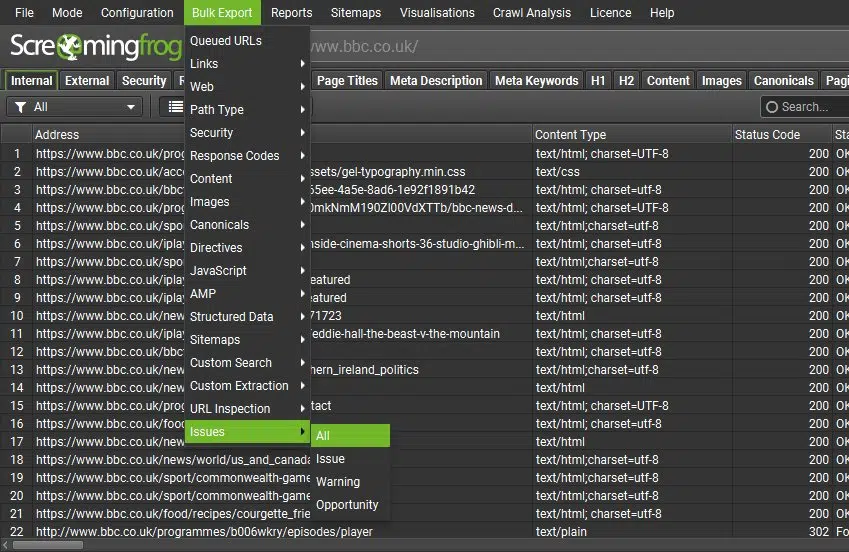

Wszystkie problemy można wyeksportować zbiorczo, wybierając opcję "Bulk Export > Issues > All". Spowoduje to wyeksportowanie każdego wykrytego problemu (w tym jego wariantów "linków wewnętrznych", takich jak uszkodzone linki) do osobnego arkusza kalkulacyjnego w folderze (jako CSV, Excel i Arkusze).

www.screamingfrog.co.uk

Nowa karta "Issues" działa również z porównaniem skanowania, podobnie jak karta "Overview", aby umożliwić użytkownikom identyfikowanie miejsc, w których problemy uległy zmianie i monitorowanie postępów w czasie.

www.screamingfrog.co.uk

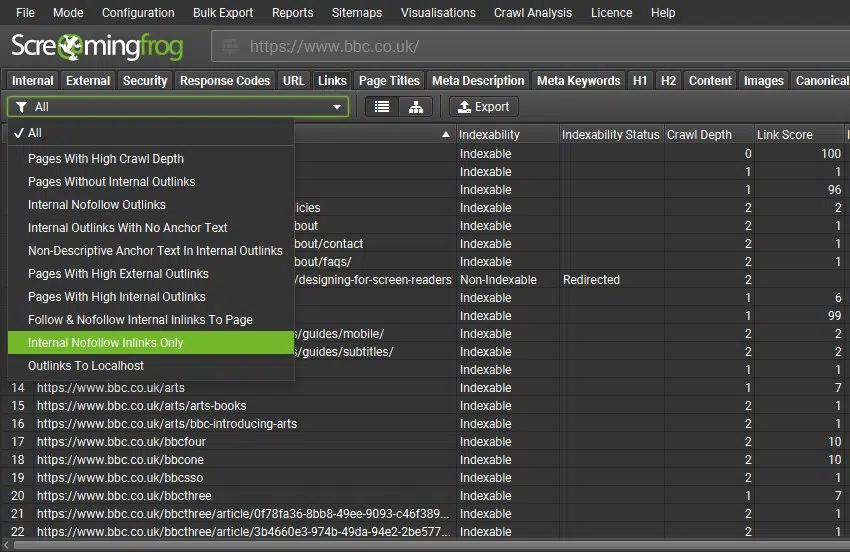

Zakładka Linki

Dostępna jest nowa karta "Links", która pomaga lepiej identyfikować problemy związane z linkami, takie jak:

- strony o dużej głębokości skanowania,

- strony bez wewnętrznych linków wychodzących,

- strony korzystające z linków wewnętrznych nofollow,

- strony z linkami wewnętrznymi bez tekstu kotwicy,

- strony z "nieopisowym" tekstem kotwicy w wewnętrznych linkach,

- strony z dużą liczbą zewnętrznych linków,

- strony z dużą liczbą wewnętrznych linków,

- linki wewnętrzne follow i nofollow prowadzące do danej strony,

- tylko wewnętrzne linki nofollow,

- linki prowadzące do localhost.

www.screamingfrog.co.uk

Filtry, takie jak duża liczba wewnętrznych i zewnętrznych linków oraz nieopisowy tekst kotwicy, można dostosować w sekcji "Config > Spider > Preferences" do limitów preferowanych przez użytkownika.

Wszystkie dane można eksportować wraz ze stronami źródłowymi również za pomocą menu "Bulk Export > Links".

Nowe limity

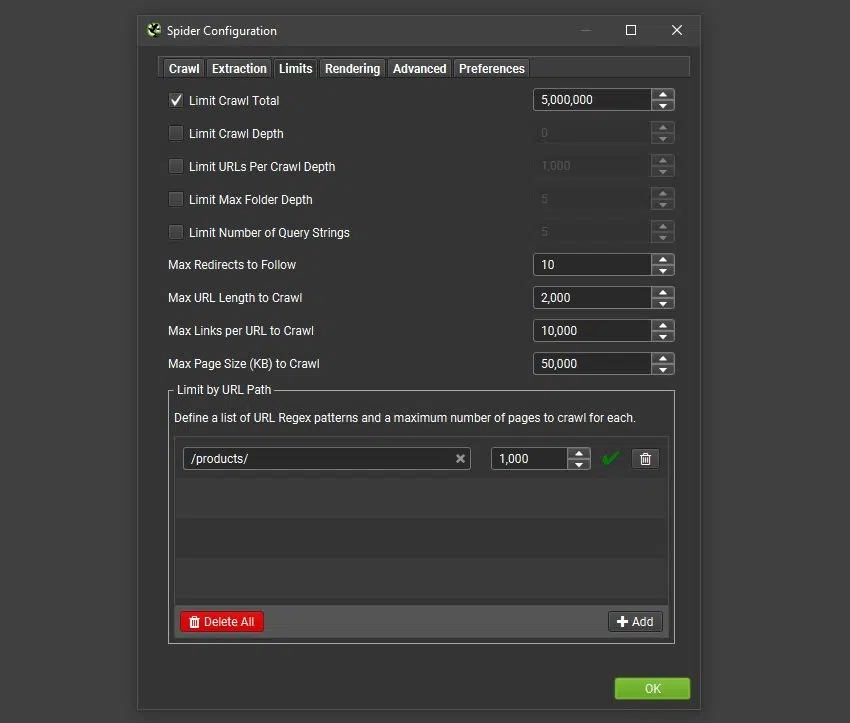

Użytkownicy mogą teraz kontrolować liczbę skanowanych adresów URL według ścieżki adresu URL, co zapewnia lepszą kontrolę skanowania i próbkowanie typów szablonów.

W sekcji "Config > Spider > Limits" znajduje się teraz konfiguracja "Limit by URL Path", która umożliwia wprowadzenie listy wzorców adresów URL i maksymalną liczbę stron do przeskanowania dla każdego z nich.

www.screamingfrog.co.uk

Użytkownicy mogą teraz także ograniczyć liczbę adresów URL na głębokość skanowania ("Limit URLs Per Crawl Depth"), co w niektórych scenariuszach może pomóc w lepszym próbkowaniu.

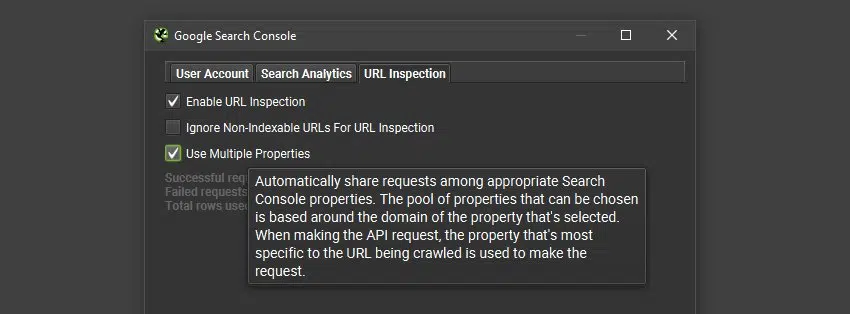

Konfiguracja "Multiple Properties" dla URL Inspection API

Interfejs URL Inspection API jest ograniczony do dwóch tysięcy zapytań na usługę Google.

Możliwe jest jednak posiadanie wielu zweryfikowanych usług (subdomen lub podfolderów) dla witryny, przy czym każda pojedyncza usługa będzie miała limit zapytań wynoszący 2 tys.

Dlatego w konfiguracji URL Inspection API ("Config > API Access > GSC > URL Inspection") użytkownicy mogą teraz wybrać "multiple properties" podczas jednego skanowania. SEO Spider automatycznie wykryje wszystkie odpowiednie właściwości na koncie i użyje najbardziej konkretnej właściwości, aby zażądać danych dla adresu URL.

www.screamingfrog.co.uk

Oznacza to, że teraz można uzyskać znacznie więcej niż 2 tys. adresów URL z interfejsu URL Inspection API podczas jednego skanowania, jeśli skonfigurowano wiele usług - bez konieczności wykonywania wielu skanowań.

Wersja Apple Silicon i RPM dla Fedory

Dostępna jest teraz natywna wersja Apple Silicon dla użytkowników na komputerach Mac M1/2 oraz RPM dla użytkowników Fedory Linux.

www.screamingfrog.co.uk

W ograniczonych testach wewnętrznych natywnej wersji Silicon odkryto, że:

- Skanowanie witryny hostowanej lokalnie z bardzo małym opóźnieniem spowodowało, że skanowanie przebiegało dwa razy szybciej.

- Wczytywanie zapisanego skanowania było 4 razy szybsze.

- Natywne wrażenia są o wiele bardziej płynne w porównaniu do korzystania z warstwy emulacji Rosetta2.

Odpinane zakładki

Wszystkie zakładki można teraz odłączyć. Użytkownicy mogą kliknąć prawym przyciskiem myszy i następnie wybrać opcję odłączyć ("Detach") dowolną kartę z głównego interfejsu użytkownika i przenieść do preferowanej pozycji (na wielu ekranach).

www.screamingfrog.co.uk

Więcej szczegółów na stronie: https://www.screamingfrog.co.uk/seo-spider-17/